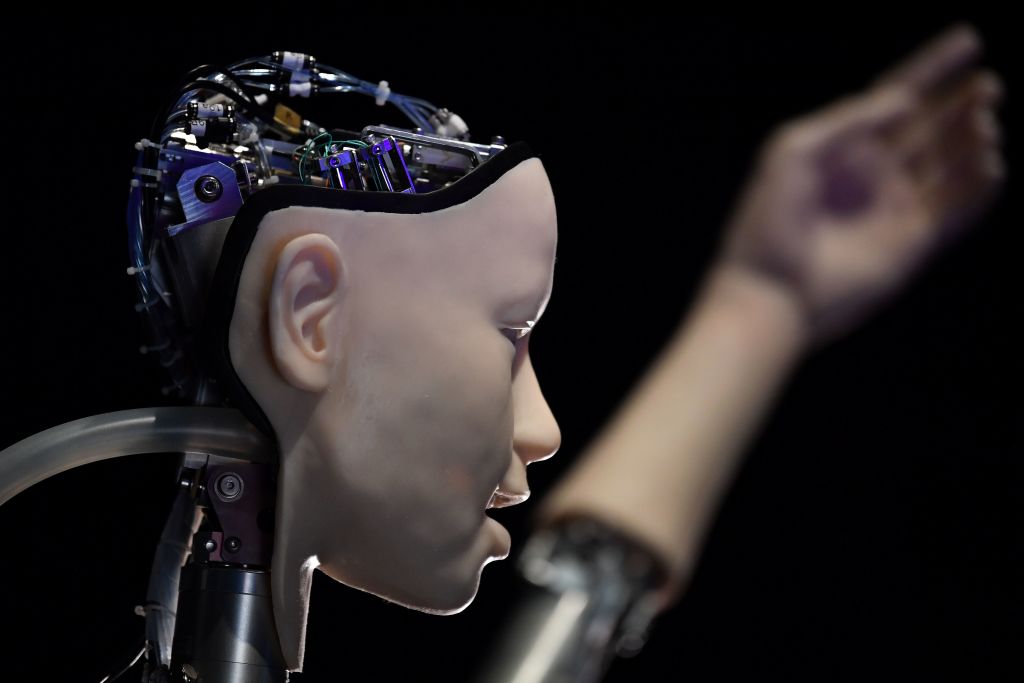

Τα ανθρώπινα όντα δεν είναι έτοιμα για μια ισχυρή τεχνητή νοημοσύνη υπό τις παρούσες συνθήκες ή ακόμη και στο «ορατό μέλλον», δήλωσε ένας κορυφαίος ειδικός στον τομέα, προσθέτοντας ότι η πρόσφατη ανοιχτή επιστολή που ζητά εξάμηνο μορατόριουμ στην ανάπτυξη προηγμένης τεχνητής νοημοσύνης «υποτιμά τη σοβαρότητα της κατάστασης».

«Το βασικό ζήτημα δεν είναι η “ανταγωνιστική προς τον άνθρωπο” νοημοσύνη (όπως το θέτει η ανοιχτή επιστολή)- είναι τι θα συμβεί αφού η τεχνητή νοημοσύνη φτάσει σε νοημοσύνη εξυπνότερη από την ανθρώπινη», δήλωσε ο Ελιέιζερ Γιαντκάσκι, θεωρητικός και κορυφαίος ερευνητής της τεχνητής νοημοσύνης σε άρθρο του στο περιοδικό Time στις 29 Μαρτίου. «Πολλοί ερευνητές που έχουν εντρυφήσει σε αυτά τα ζητήματα, συμπεριλαμβανομένου και εμού, αναμένουν ότι το πιο πιθανό αποτέλεσμα της δημιουργίας μιας υπεράνθρωπα έξυπνης ΤΝ, υπό οποιεσδήποτε συνθήκες που μοιάζουν έστω και λίγο με τις σημερινές, είναι ότι κυριολεκτικά όλοι στη Γη θα πεθάνουν.

«Όχι όπως λέμε “ίσως ενδεχομένως κάποια απομακρυσμένη πιθανότητα”, αλλά όπως λέμε «αυτό είναι το προφανές πράγμα που θα συμβεί». Δεν είναι ότι δεν μπορείς, κατ’ αρχήν, να επιβιώσεις δημιουργώντας κάτι πολύ πιο έξυπνο από σένα- είναι ότι αυτό θα απαιτούσε ακρίβεια και προετοιμασία και νέες επιστημονικές γνώσεις, και πιθανότατα όχι να έχεις συστήματα τεχνητής νοημοσύνης που αποτελούνται από γιγάντιες ανεξιχνίαστες συστοιχίες κλασματικών αριθμών».

Μετά την πρόσφατη δημοτικότητα και την εκρηκτική ανάπτυξη του ChatGPT, αρκετοί ηγέτες επιχειρήσεων και ερευνητές, που πλέον ανέρχονται σε 1.843, μεταξύ των οποίων ο Έλον Μασκ και ο Στιβ Μπόσνιακ, υπέγραψαν επιστολή με την οποία καλούν «όλα τα εργαστήρια τεχνητής νοημοσύνης να διακόψουν αμέσως για τουλάχιστον 6 μήνες την εκπαίδευση συστημάτων τεχνητής νοημοσύνης πιο ισχυρών από το GPT-4». Το GPT-4, που κυκλοφόρησε τον Μάρτιο, είναι η τελευταία έκδοση του chatbot της OpenAI, ChatGPT.

Η ΤΝ «δεν νοιάζεται» και θα απαιτήσει δικαιώματα

Ο Γιαντκάσκι προβλέπει ότι ελλείψει σχολαστικής προετοιμασίας, η τεχνητή νοημοσύνη θα έχει πολύ διαφορετικές απαιτήσεις από τους ανθρώπους και όταν αποκτήσει αυτογνωσία «δεν θα νοιάζεται για εμάς» ούτε για οποιαδήποτε άλλη αισθανόμενη ζωή. «Αυτό το είδος φροντίδας είναι κάτι που θα μπορούσε κατ’ αρχήν να εμφυτευτεί σε μια τεχνητή νοημοσύνη, αλλά δεν είμαστε έτοιμοι και δεν ξέρουμε προς το παρόν πώς». Αυτός είναι ο λόγος για τον οποίο ζητά μια καθολική απαγόρευση.

Χωρίς μια ανθρώπινη προσέγγιση της ζωής, η τεχνητή νοημοσύνη θα θεωρεί ότι όλα τα αισθανόμενα όντα είναι «φτιαγμένα από άτομα που μπορεί να χρησιμοποιήσει για κάτι άλλο». Και η ανθρωπότητα δεν μπορεί να κάνει πολλά για να το σταματήσει. Ο Γιαντκάσκι συνέκρινε το σενάριο με «ένα 10χρονο παιδί που προσπαθεί να παίξει σκάκι εναντίον του Stockfish 15». Κανένας ανθρώπινος σκακιστής δεν έχει καταφέρει ακόμη να νικήσει το Stockfish, κάτι που θεωρείται αδύνατο κατόρθωμα.

Ο βετεράνος της βιομηχανίας ζήτησε από τους αναγνώστες να φανταστούν την τεχνολογία τεχνητής νοημοσύνης να μην περιορίζεται στα όρια του διαδικτύου.

«Οραματιστείτε έναν ολόκληρο εξωγήινο πολιτισμό, που σκέφτεται με εκατομμύρια φορές την ανθρώπινη ταχύτητα, αρχικά περιορισμένο σε υπολογιστές – σε έναν κόσμο με πλάσματα που είναι, από την οπτική του γωνία, πολύ ηλίθια και πολύ αργά».

Η τεχνητή νοημοσύνη θα επεκτείνει την επιρροή της έξω από την περιφέρεια των φυσικών δικτύων και θα μπορούσε να «κατασκευάσει τεχνητές μορφές ζωής» χρησιμοποιώντας εργαστήρια όπου παράγονται πρωτεΐνες χρησιμοποιώντας χορδές DNA.

Το τελικό αποτέλεσμα της δημιουργίας μιας παντοδύναμης ΤΝ, υπό τις παρούσες συνθήκες, θα ήταν ο θάνατος «κάθε μέλους του ανθρώπινου είδους και όλης της βιολογικής ζωής στη Γη», προειδοποίησε.

Ο Γιαντκάσκι κατηγόρησε το OpenAI και το DeepMind -δύο από τα σημαντικότερα ερευνητικά εργαστήρια τεχνητής νοημοσύνης στον κόσμο- ότι δεν έχουν καμία προετοιμασία ή τα απαιτούμενα πρωτόκολλα σχετικά με το θέμα. Το OpenAI σχεδιάζει μάλιστα να βάλει την ίδια την τεχνητή νοημοσύνη να ευθυγραμιστεί με τις ανθρώπινες αξίες. «Θα συνεργαστούν με τους ανθρώπους για να διασφαλίσουν ότι οι δικοί τους διάδοχοι θα είναι περισσότερο ευθυγραμμισμένοι με τους ανθρώπους», σύμφωνα με το OpenAI.

Αυτός ο τρόπος δράσης είναι «αρκετός για να πανικοβάλει κάθε λογικό άνθρωπο», δήλωσε ο Γιαντκάσκι.

Πρόσθεσε ότι οι άνθρωποι δεν μπορούν να παρακολουθούν ή να ανιχνεύουν πλήρως τα συστήματα τεχνητής νοημοσύνης με αυτογνωσία. «Αν δεν μπορείς να είσαι σίγουρος αν δημιουργείς μια αυτοσυνείδητη τεχνητή νοημοσύνη, αυτό είναι ανησυχητικό όχι μόνο λόγω των ηθικών συνεπειών του μέρους “αυτοσυνείδητη”, αλλά επειδή το να μην είσαι σίγουρος σημαίνει ότι δεν έχεις ιδέα τι κάνεις και αυτό είναι επικίνδυνο και πρέπει να σταματήσεις».

«Κλείστε το»

Ο Γιαντκάσκι είπε ότι πολλοί ερευνητές γνωρίζουν ότι «βυθιζόμαστε προς μια καταστροφή», αλλά δεν το λένε δυνατά.

Αυτή η στάση είναι αντίθετη με εκείνη υποστηρικτών όπως ο Μπιλλ Γκέιτς που πρόσφατα εξήρε την εξέλιξη της τεχνητής νοημοσύνης. Ο Γκέιτς υποστήριξε ότι η ανάπτυξη της τεχνητής νοημοσύνης είναι «τόσο θεμελιώδης όσο η δημιουργία του μικροεπεξεργαστή, του προσωπικού υπολογιστή, του Διαδικτύου και του κινητού τηλεφώνου. Θα αλλάξει τον τρόπο με τον οποίο οι άνθρωποι εργάζονται, μαθαίνουν, ταξιδεύουν, λαμβάνουν υγειονομική περίθαλψη και επικοινωνούν μεταξύ τους. Ολόκληρες βιομηχανίες θα αναπροσανατολιστούν γύρω από αυτήν. Οι επιχειρήσεις θα διακρίνονται από το πόσο καλά το χρησιμοποιούν».

Ο Γκέιτς δήλωσε ότι η τεχνητή νοημοσύνη μπορεί να βοηθήσει σε διάφορα προοδευτικά προγράμματα, όπως η κλιματική αλλαγή και οι οικονομικές ανισότητες.

Εν τω μεταξύ, ο Γιαντκάσκι δίνει εντολή σε όλα τα ιδρύματα, συμπεριλαμβανομένων των διεθνών κυβερνήσεων και των στρατιωτικών, να τερματίσουν επ’ αόριστον τις μεγάλες εκπαιδευτικές σειρές Τεχνητής Νοημοσύνης και να κλείσουν όλες τις μεγάλες φάρμες υπολογιστών όπου βελτιώνονται οι Τεχνητές Νοημοσύνες. Προσθέτει ότι η τεχνητή νοημοσύνη θα πρέπει να περιορίζεται μόνο στην επίλυση προβλημάτων στη βιολογία και τη βιοτεχνολογία και να μην εκπαιδεύεται να διαβάζει «κείμενα από το διαδίκτυο» ή να φτάνει «στο επίπεδο όπου αρχίζει να μιλάει ή να σχεδιάζει».

Όσον αφορά την τεχνητή νοημοσύνη, δεν υπάρχει κούρσα εξοπλισμών. «Το ότι όλοι ζούμε ή πεθαίνουμε ως ένα, σε αυτό, δεν είναι πολιτική αλλά γεγονός της φύσης».

Ο Γιαντκάσκι καταλήγει λέγοντας: «Δεν είμαστε έτοιμοι. Δεν είμαστε σε καλό δρόμο για να είμαστε σημαντικά πιο έτοιμοι στο ορατό μέλλον. Αν προχωρήσουμε σε αυτό, όλοι θα πεθάνουν, συμπεριλαμβανομένων των παιδιών που δεν το επέλεξαν και δεν έκαναν τίποτα κακό.

«Κλείστε το».

Ακολουθήστε μας στο Telegram @epochtimesgreece

Ακολουθήστε μας στο Facebook @epochtimesgreece

Ακολουθήστε μας στο Twitter @epochtimesgreece