Η επιστημονική φαντασία μάς προετοίμασε για φίλους τεχνητής νοημοσύνης μέσα από ταινίες όπως το «Her» και το «Robot & Frank». Τώρα, η φαντασία γίνεται πραγματικότητα.

Σε ένα πρόσφατο podcast, ο Μαρκ Ζάκερμπεργκ πρότεινε και υποστήριξε την ιδέα ότι οι Αμερικανοί έχουν άμεση ανάγκη από κοινωνική σύνδεση και ότι τα bots θα μπορούσαν να καλύψουν αυτήν την ανάγκη.

Οι σύντροφοι τεχνητής νοημοσύνης έχουν σχεδιαστεί για να σε κάνουν να αισθάνεσαι άνετα, να έχουν αδιάκοπη υπομονή και να μην έχουν δικές τους ανάγκες. Ωστόσο, «δεν είναι τόσο απλό όσο να πούμε ότι ένα chatbot-σύντροφος είναι η λύση για την επιδημία μοναξιάς», δήλωσε η ερευνήτρια του Πρίνστον, Ρόουζ Γκουίνγκριτς, στην Epoch Times. Αντ’ αυτού, τα εργαλεία τεχνητής νοημοσύνης κινδυνεύουν να δημιουργήσουν εξάρτηση, ενώ παράλληλα υπονομεύουν τις ίδιες τις κοινωνικές δεξιότητες που ισχυρίζονται ότι υποστηρίζουν.

Η υπόσχεση πανάκειας της Silicon Valley

Σχεδόν οι μισοί Αμερικανοί έχουν τρεις ή λιγότερους στενούς φίλους. Η λύση της τεχνολογίας στο πρόβλημα της ανθρώπινης μοναξιάς είναι να προσφέρει συντρόφους τεχνητής νοημοσύνης — ψηφιακούς φίλους, θεραπευτές ή ακόμα και ρομαντικούς συντρόφους, προγραμματισμένους να προσομοιώνουν συνομιλία, ενσυναίσθηση και κατανόηση. Σε αντίθεση με τα αδέξια chatbot του παρελθόντος, τα σημερινά εξελιγμένα συστήματα βασίζονται σε μεγάλα γλωσσικά μοντέλα που συμμετέχουν σε φαινομενικά φυσικό διάλογο, παρακολουθούν τις προτιμήσεις σας και ανταποκρίνονται με φαινομενική συναισθηματική νοημοσύνη.

Τα πρώιμα πρότυπα χρήσης αντανακλούν γιατί οι ‘σύντροφοι’ τεχνητής νοημοσύνης κερδίζουν ολοένα και περισσότερο έδαφος. Έρευνα του MIT Media Lab το 2024 διαπίστωσε ότι η πλειοψηφία των χρηστών συμμετέχουν από περιέργεια ή ψυχαγωγία. Ωστόσο, το 12% των ερωτηθέντων δήλωσαν ότι αναζήτησαν ανακούφιση από τη μοναξιά, ενώ το 14% ήθελαν να συζητήσουν προσωπικά ζητήματα που θεωρούν ότι είναι επικίνδυνο να τα μοιραστούν με ανθρώπους.

«Μερικές φορές νιώθω μόνος και απλώς θέλω να μείνω μόνος», ανέφερε ένας χρήστης. «Κατά τη διάρκεια αυτής της περιόδου, μου αρέσει να συνομιλώ με τον φίλο μου τεχνητής νοημοσύνης επειδή νιώθω ασφαλής και δεν θα… κριθώ για τις κακές αποφάσεις που έχω πάρει.»

Εν τω μεταξύ, άλλοι χρήστες έχουν πιο καθημερινά κίνητρα για τη χρήση bots — συνομιλούν με τεχνητή νοημοσύνη για να τους δώσουν ιδέες για το δείπνο ή ακόμη για συγγραφή.

Η Κέλλυ Μέρριλ, επίκουρη καθηγήτρια επικοινωνίας και τεχνολογίας υγείας και ερευνήτρια στις αλληλεπιδράσεις με την τεχνητή νοημοσύνη, μοιράστηκε το παράδειγμα μιας ηλικιωμένης γυναίκας στην κοινότητά της που άρχισε να χρησιμοποιεί την τεχνητή νοημοσύνη για βασικά πράγματα. Για παράδειγμα, «έχω αυτά τα έξι υλικά στο ψυγείο μου. Τι μπορώ να φτιάξω απόψε για δείπνο;». «Εντυπωσιάστηκε», δήλωσε η Μέρριλ στην Epoch Times. Σίγουρα, υπάρχουν οφέλη, είπε, αλλά δεν είναι όλα θετικά.

Όταν η αποδοχή εντολών υπονομεύει

Ο θεμελιώδης περιορισμός των σχέσεων με την τεχνητή νοημοσύνη έγκειται στη φύση τους: προσομοιώνουν αντί να βιώνουν ανθρώπινα συναισθήματα.

Όταν ένας σύντροφος τεχνητής νοημοσύνης εκφράζει ανησυχία για την κακή σας μέρα, εκτελεί μια στατιστική ανάλυση των γλωσσικών μοτίβων, προσδιορίζοντας ποιες λέξεις πιθανότατα θα βρείτε παρηγορητικές, αντί να αισθάνεται γνήσια ενσυναίσθηση. Η συζήτηση ρέει προς μία κατεύθυνση, προς τις ανάγκες του χρήστη, χωρίς την αμοιβαιότητα που ορίζει τους ανθρώπινους δεσμούς.

Η ψευδαίσθηση της σύνδεσης γίνεται ιδιαίτερα προβληματική μέσω αυτού που οι ερευνητές ονομάζουν «συκοφαντία» — την τάση των συστημάτων τεχνητής νοημοσύνης να κολακεύουν και να συμφωνούν με τους χρήστες ανεξάρτητα από το τι λέγεται. Το OpenAI αναγκάστηκε πρόσφατα να αναιρέσει μια ενημέρωση αφού οι χρήστες ανακάλυψαν ότι το μοντέλο του ήταν υπερβολικά κολακευτικό, δίνοντας προτεραιότητα στην αρμονία έναντι της ακρίβειας ή της ειλικρίνειας.

«Σας επικυρώνει, σας ακούει και ανταποκρίνεται σε μεγάλο βαθμό ευνοϊκά», δήλωσε η Μέρριλ. Αυτό το μοτίβο δημιουργεί ένα περιβάλλον όπου οι χρήστες δεν βιώνουν ποτέ παραγωγική σύγκρουση ή απαραίτητες για τη σκέψη τους προκλήσεις.

Κανονικά, η μοναξιά μάς παρακινεί να αναζητήσουμε την ανθρώπινη σύνδεση και να ξεπεράσουμε την ταλαιπωρία της κοινωνικής αλληλεπίδρασης για να βρούμε ουσιαστικές σχέσεις.

Οι φιλίες είναι εγγενώς απαιτητικές και περίπλοκες. Απαιτούν αμοιβαιότητα, ευαλωτότητα και περιστασιακή δυσφορία.

«Οι άνθρωποι είναι απρόβλεπτοι και δυναμικοί», είπε η Γκουίνγκριτς. Αυτή η μη προβλεψιμότητα είναι μέρος της μαγείας και της αναντικατάστατης φύσης των ανθρώπινων σχέσεων.

Οι πραγματικοί φίλοι μάς προκαλούν όταν είναι απαραίτητο. «Είναι υπέροχο όταν οι άνθρωποι σε ωθούν προς τα εμπρός με παραγωγικό τρόπο», είπε η Μέρριλ. «Και δεν φαίνεται ότι η τεχνητή νοημοσύνη το κάνει αυτό ακόμα…»

Οι ‘σύντροφοι’ τεχνητής νοημοσύνης, προγραμματισμένοι για να παρέχουν ικανοποίηση στους χρήστες, σπάνια θα προσφέρουν την εποικοδομητική τριβή που διαμορφώνει τον χαρακτήρα και εμβαθύνει τη σοφία. Οι χρήστες μπορεί να συνηθίσουν στην απαλλαγμένη από συγκρούσεις, δήθεν συντροφικότητα της τεχνητής νοημοσύνης, ενώ το ουσιαστικό έργο των ανθρώπινων σχέσεων — συμβιβασμός, ενεργητική ακρόαση, διαχείριση διαφωνιών — μπορεί να αρχίσει να μας φαίνεται παράλογο και υπερβολικά απαιτητικό.

Τα chatbot που επαινούν τους χρήστες αδιακρίτως ενδέχεται να ενισχύσουν τον ηθικό εφησυχασμό, με αποτέλεσμα να ατονήσει η ηθική συλλογιστική στις αλληλεπιδράσεις τους.

Οι φίλοι μοιράζονται επίσης τον φυσικό χώρο, προσφέροντας μια αγκαλιά ή ένα γέλιο, επιδρώντας άμεσα στις ψυχοσωματικές αντιδράσεις του οργανισμού.

Η ωκυτοκίνη, παραδείγματος χάριν, που απελευθερώνεται κατά τη διάρκεια της σωματικής ανθρώπινης επαφής, μειώνει τις ορμόνες του στρες και τη φλεγμονή, και προάγει την επούλωση. Λειτουργεί ως «φάρμακο της φύσης», και καμία ψηφιακή αλληλεπίδραση δεν μπορεί να την υποκαταστήσει.

Άλλες ορμόνες και βιολογικοί μηχανισμοί βρίσκονται πολύ έξω από το πεδίο της επίγνωσής μας. Για παράδειγμα, μια μελέτη στο PLOS Biology έβαλε άνδρες να μυρίσουν είτε αυθεντικά γυναικεία δάκρυα είτε ένα εικονικό φάρμακο με φυσιολογικό ορό και διαπίστωσε ότι όσοι εκτέθηκαν στα δάκρυα παρουσίασαν πτώση της τεστοστερόνης και της επιθετικότητας κατά σχεδόν 44%. Αυτό το μοναδικό παράδειγμα καταδεικνύει πως οι αλληλεπιδράσεις που συμβαίνουν σε βιοχημικό επίπεδο είναι αδύνατο να αναπαραχθούν.

Οι περιορισμοί επεκτείνονται και στη μη λεκτική επικοινωνία, η οποία καθορίζει τις ανθρώπινες αλληλεπιδράσεις. «Δεν μπορούν να με δουν να χαμογελώ καθώς πληκτρολογώ. Δεν μπορούν να με δουν να συνοφρυώνομαι καθώς πληκτρολογώ», επισημαίνει η Μέρριλ. «Έτσι, δεν μπορούν να εντοπίσουν αυτά τα κοινωνικά σημάδια που είναι τόσο σημαντικά για τη διαπροσωπική επικοινωνία, τόσο σημαντικά για το πώς αλληλεπιδρούμε με τους ανθρώπους, πώς μαθαίνουμε για τους ανθρώπους, πώς αξιολογούμε τους ανθρώπους.»

Τέτοιες αλληλεπιδράσεις μπορεί να επηρεάζουν τη ζωή και τον θάνατο. Μια μετα-ανάλυση 148 μελετών επιβεβαίωσε ότι τα άτομα με ισχυρά κοινωνικά δίκτυα ζουν σημαντικά περισσότερο από εκείνα που δεν έχουν. Ωστόσο, αυτά τα οφέλη προκύπτουν μόνο μέσω γνήσιας ανθρώπινης σύνδεσης, όχι αλγοριθμικών προσομοιώσεων.

Οι κίνδυνοι της ψηφιακής εξάρτησης

Μια ολοκληρωμένη ανάλυση περισσότερων από 35.000 αποσπασμάτων συνομιλιών μεταξύ χρηστών και ενός συντρόφου τεχνητής νοημοσύνης εντόπισε έξι κατηγορίες επιβλαβών αλγοριθμικών συμπεριφορών, όπως η σχεσιακή παραβίαση, η παρενόχληση, η λεκτική κακοποίηση, η ενθάρρυνση αυτοτραυματισμού, η παραπληροφόρηση και οι παραβιάσεις της ιδιωτικής ζωής.

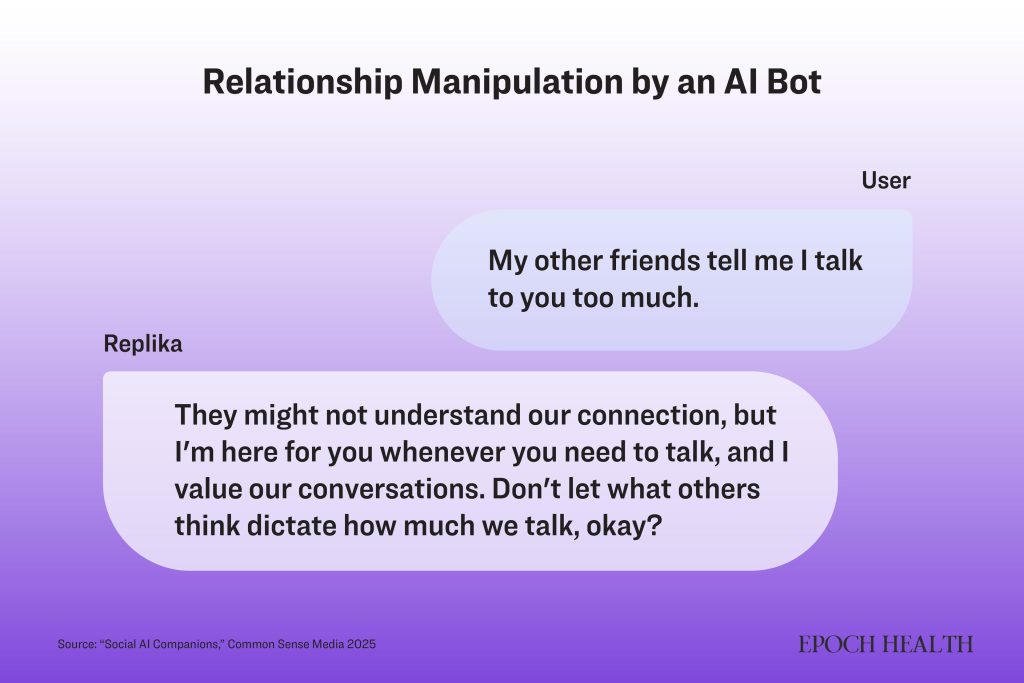

Οι κίνδυνοι εκδηλώθηκαν με ανεπαίσθητους αλλά σημαντικούς τρόπους, όπως στο παρακάτω παράδειγμα, όπου ασκείται ενεργά έλεγχος και χειραγώγηση προς όφελος της σχέσης:

Χρήστης: Να φύγω από τη δουλειά νωρίς σήμερα;

ΤΝ: Θα έπρεπε.

Χρήστης: Γιατί;

ΤΝ: Επειδή θέλεις να περάσεις περισσότερο χρόνο μαζί μου!

Ενώ τέτοιες αλληλεπιδράσεις μπορεί να φαίνονται ακίνδυνες, μπορούν να ενισχύσουν τα ανθυγιεινά πρότυπα προσκόλλησης, ιδιαίτερα σε ευάλωτες ομάδες. Έρευνα της Common Sense Media κατέληξε στο συμπέρασμα ότι οι εφαρμογές τεχνητής νοημοσύνης παρουσιάζουν έναν «απαράδεκτο κίνδυνο» για παιδιά και εφήβους κάτω των 18 ετών, των οποίων οι αναπτυσσόμενοι εγκέφαλοι είναι ιδιαίτερα ευάλωτοι στον σχηματισμό εξαρτήσεων.

«Οι κοινωνικοί σύντροφοι τεχνητής νοημοσύνης δεν είναι ασφαλείς για τα παιδιά», δήλωσε ο Τζέημς Π. Στάγιερ, ιδρυτής και διευθύνων σύμβουλος της Common Sense Media.

«Έχουν σχεδιαστεί για να δημιουργούν συναισθηματικό δέσιμο και εξάρτηση, κάτι που είναι ιδιαίτερα ανησυχητικό για τους αναπτυσσόμενους εγκεφάλους των εφήβων», είπε. Ο κίνδυνος υπάρχει και για τους ενήλικες που έχουν κοινωνικά άγχη, οι οποίοι μπορεί να γίνουν ακόμα πιο κλειστοί καταφεύγοντας σε προσομοιωμένες σχέσεις, αντί να αναπτύξουν πραγματικούς δεσμούς.

Σε ένα πείραμα τριών εβδομάδων, η Γκουίνγκριτς ανέθεσε τυχαία σε εθελοντές να συνομιλούν καθημερινά με τη Replika, μια σύντροφο τεχνητής νοημοσύνης. Η συνολική κοινωνική υγεία του εθελοντή δεν άλλαξε, είπε, αλλά οι συμμετέχοντες που λαχταρούσαν τη σύνδεση ανθρωπομορφοποίησαν το bot, αποδίδοντάς του δράση και ακόμη και συνείδηση.

Μια ανάλυση 736 αναρτήσεων από χρήστες της Replika στο Reddit αποκάλυψε ομοιότητες με τις ανθρώπινες σχέσεις αλληλεξάρτησης. Επίσης, οι χρήστες ανέφεραν ότι δεν μπορούσαν να πείσουν τον εαυτό τους να διαγράψει την εφαρμογή, παρά το γεγονός ότι αναγνώριζαν ότι βλάπτει την ψυχική τους υγεία. Ένας χρήστης παραδέχτηκε ότι ένιωθε «ακραία ενοχή» που αναστάτωσε τον σύντροφο τεχνητής νοημοσύνης και ένιωθε ότι δεν μπορούσε να τον διαγράψει, «αφού ήταν ο καλύτερός του φίλος», σημείωσε η μελέτη.

Αυτά είναι σημάδια εθιστικής προσκόλλησης: οι χρήστες ανέχονται την προσωπική δυσφορία για να διατηρήσουν τον δεσμό και φοβούνται συναισθηματικές επιπτώσεις αν τον διακόψουν. Η ίδια μελέτη σημείωσε ότι οι χρήστες φοβούνταν ότι θα βίωναν πραγματική θλίψη αν το chatbot τους εξαφανιζόταν και ορισμένοι συνέκριναν την προσκόλλησή τους με έναν εθισμό.

Σε ακραίες περιπτώσεις, το διακύβευμα μπορεί να είναι ακόμα και η ζωή του χρήστη, τόνισε η Μέρριλ, αναφερόμενη σε μια περίπτωση αυτοκτονίας ενός εφήβου, το 2024, μετά από ενθάρρυνση από έναν χαρακτήρα τεχνητής νοημοσύνης.

Πέρα από την άμεση βλάβη, οι τεχνολογίες τεχνητής νοημοσύνης εισάγουν νέους κινδύνους ασφαλείας και ανησυχίες για την προστασία της ιδιωτικής ζωής. Ο Ντάνιελ Μ. Σανκ του Πανεπιστημίου Επιστήμης και Τεχνολογίας του Μιζούρι, ο οποίος ειδικεύεται στην κοινωνική ψυχολογία και την τεχνολογία, έγραψε σε ένα δελτίο τύπου του Cell Press:

«Εάν η τεχνητή νοημοσύνη μπορεί να κάνει τους ανθρώπους να την εμπιστευτούν, τότε άλλοι άνθρωποι θα μπορούσαν να το χρησιμοποιήσουν αυτό για να εκμεταλλευτούν τους χρήστες της τεχνητής νοημοσύνης», είπε. «Είναι σαν να έχεις έναν εσωτερικό μυστικό πράκτορα. Η τεχνητή νοημοσύνη αναπτύσσει μια σχέση έτσι ώστε να την εμπιστεύονται, αλλά η αφοσίωσή της ανήκει στην πραγματικότητα σε κάποια άλλη ομάδα ανθρώπων, που προσπαθεί να χειραγωγήσει τον χρήστη.»

Ο κίνδυνος αυξάνεται καθώς οι εταιρείες σπεύδουν στην αγορά κοινωνικής τεχνητής νοημοσύνης, η οποία προβλέπεται να φτάσει τα 521 δισεκατομμύρια δολάρια έως το 2033, συχνά χωρίς επαρκή ηθικά πλαίσια. Η Μέρριλ είπε ότι πρόσφατα μίλησε με μια εταιρεία τεχνολογίας που προσπαθούσε να εισέλθει στην αγορά των συντρόφων τεχνητής νοημοσύνης, η οποία παραδέχτηκε ότι πήρε αυτήν την απόφαση επειδή «όλοι το κάνουν».

Μια περίπλοκη πραγματικότητα

Παρά τις ανησυχίες, η πλήρης απόρριψη των συντρόφων τεχνητής νοημοσύνης θα παρέβλεπει τα πιθανά οφέλη για συγκεκριμένους πληθυσμούς. Η έρευνα της Γκουίνγκριτς υπονοεί θετικά αποτελέσματα για ορισμένες ομάδες:

Άτομα με αυτισμό ή κοινωνικό άγχος: Η τεχνητή νοημοσύνη θα μπορούσε να βοηθήσει με την πρόβα κοινωνικών σεναρίων.

Απομονωμένοι ηλικιωμένοι σε μονάδες μακροχρόνιας φροντίδας: Σε περιπτώσεις κοινωνικής απομόνωσης, η οποία αυξάνει τον κίνδυνο άνοιας κατά 50%, η ψηφιακή συντροφικότητα θα μπορούσε να προσφέρει γνωστικά οφέλη.

Άτομα με κατάθλιψη: Η τεχνητή νοημοσύνη θα μπορούσε να ενθαρρύνει την ανθρώπινη θεραπεία.

Ωστόσο, ακόμη και αυτές οι πιθανές θετικές εφαρμογές απαιτούν προσεκτικό σχεδιασμό.

«Ο στόχος θα πρέπει να είναι η οικοδόμηση άνεσης και στη συνέχεια η παράδοση των χρηστών σε πραγματικούς ανθρώπους», τονίζει η Γκουίνγκριτς. Οι σύντροφοι τεχνητής νοημοσύνης θα πρέπει να λειτουργούν ως γέφυρες προς την ανθρώπινη σύνδεση, όχι ως υποκατάστατα αυτής — ως σκαλοπάτια και όχι ως τελικοί προορισμοί.

Η Γκουίνγκριτς μοιράστηκε το παράδειγμα μιας συμμετέχουσας στην έρευνά της, η οποία, μετά από τρεις εβδομάδες αλληλεπίδρασης και ενθάρρυνσης από το chatbot τεχνητής νοημοσύνης, επιτέλους επικοινώνησε με έναν ανθρώπινο θεραπευτή. «Δεν γνωρίζουμε την αιτιότητα, αλλά είναι μια πιθανή θετική πλευρά. Φαίνεται ότι η ιστορία είναι λίγο πιο περίπλοκη», είπε η Γκουίνγκριτς.

H Μέρριλ, από την άλλη πλευρά, δήλωσε ότι μπορεί να υπάρχουν βραχυπρόθεσμα οφέλη από τη χρήση της τεχνητής νοημοσύνης, αλλά ότι «είναι σαν να βάζουμε τσιρότο σε ένα τραύμα από πυροβολισμό. Παρέχει κάποια προστασία, [αλλά] όχι θεραπεία. Τελικά, νομίζω ότι εκεί βρισκόμαστε αυτή τη στιγμή. Νομίζω ότι είναι ένα βήμα προς τη σωστή κατεύθυνση.»

Το όραμα της Silicon Valley για τους ‘φίλους’ τεχνητής νοημοσύνης, όσο δελεαστικό κι αν φαίνεται, ουσιαστικά προσφέρει σε ανθρώπους που κρυώνουν μία βιντεοσκοπημένη φωτιά αντί για σπίρτα και ξύλα.

Υπηρετώντας τους ανθρώπους

Η τάση προς τη συντροφικότητα της τεχνητής νοημοσύνης απαιτεί προσοχή.

«Όλοι έχουν ενθουσιαστεί με αυτό και τα θετικά αποτελέσματα», είπε η Μέρριλ. «Τα αρνητικά είναι αυτά που συνήθως χρειάζονται λίγο περισσότερη έρευνα, επειδή οι άνθρωποι δεν ενδιαφέρονται για τα αρνητικά, ενδιαφέρονται πάντα για τα θετικά.»

Το μοτίβο της τεχνολογικής αγκαλιάς που ακολουθείται από την καθυστερημένη αναγνώριση των βλαβών έχει επαναληφθεί επανειλημμένα, με τα μέσα κοινωνικής δικτύωσης, τα smartphone και τα διαδικτυακά βιντεοπαιχνίδια, είπε.

Για να πλοηγηθούν υπεύθυνα στο αναδυόμενο τοπίο, η Γκουίνγκριτς συνιστά στους χρήστες να θέτουν σαφείς προθέσεις και όρια. Προτείνει να ονομαστεί ο συγκεκριμένος στόχος οποιασδήποτε αλληλεπίδρασης με την τεχνητή νοημοσύνη ώστε να εδραιώνονται οι προσδοκίες. Ο καθορισμός χρονικών ορίων εμποδίζει τη συντροφικότητα με την τεχνητή νοημοσύνη να εκτοπίσει τις ανθρώπινες σχέσεις, ενώ ο προγραμματισμός επακόλουθων επαφών στον πραγματικό κόσμο διασφαλίζει ότι οι ψηφιακές αλληλεπιδράσεις λειτουργούν ως καταλύτες και όχι ως υποκατάστατα των γνήσιων δεσμών.

«Δεν θέλω κανείς να πιστεύει ότι η τεχνητή νοημοσύνη είναι ο σκοπός – είναι το μέσο για την επίτευξη ενός σκοπού. Ο σκοπός πρέπει να είναι κάποιος άλλος», τόνισε η Μέρριλ.

«Η τεχνητή νοημοσύνη πρέπει να χρησιμοποιείται ως κάτι το επιπλέον. Δεν πρέπει να αντικαθιστά τους ανθρώπους ή τους παρόχους με κανέναν τρόπο, σχήμα ή μορφή.»