‘Ατυπη συνεδρίαση του Συμβουλίου Ασφαλείας του ΟΗΕ -γνωστή ως «φόρμουλα ‘Αρια»- με τίτλο «αξιοποιώντας την ασφαλή, χωρίς αποκλεισμούς και αξιόπιστη τεχνητή νοημοσύνη για τη διατήρηση της διεθνούς ειρήνης και ασφάλειας» διοργάνωσε η Ελλάδα μαζί με τη Γαλλία και τη Δημοκρατία της Κορέας, με συνδιοργανωτές την Αρμενία, την Ιταλία και την Ολλανδία.

Σκοπός της συνεδρίασης ήταν να εξεταστούν τα πρακτικά βήματα που μπορούν να ληφθούν από τον ΟΗΕ και το Συμβούλιο Ασφαλείας για την υπεύθυνη χρήση της τεχνητής νοημοσύνης (AI) για την προστασία της διεθνούς ειρήνης και ασφάλειας.

Οι βασικοί ομιλητές ήταν ο Γιάννης Μαστρογεωργίου, Ειδικός Γραμματέας Στρατηγικής Προοπτικής της Ελληνικής Κυβέρνησης, η Γιασμίν Αφινά, ερευνήτρια AI στο UNIDIR και η Σαρλότ Σκάνταν, Σύμβουλος Πληροφοριακής Ακεραιότητας στο Τμήμα Παγκόσμιας Επικοινωνίας του ΟΗΕ.

Η συνάντηση εστίασε σε τρέχουσες πρωτοβουλίες, προκλήσεις και ευκαιρίες σχετικά με την τεχνητή νοημοσύνη AI, ειδικά σε αποστολές διατήρησης της ειρήνης.

Πρακτικά μέτρα που συζητήθηκαν περιλάμβαναν ρυθμιστικές παρεμβάσεις, μη διάδοση, αποτροπή κακόβουλης στρατιωτικής χρήσης, καθώς και ενίσχυση του κράτους δικαίου και της κοινωνικής συνοχής.

Ο Μόνιμος Αντιπρόσωπος της Ελλάδας, πρέσβης Ευάγγελος Σέκερης, υπογράμμισε τη σημασία της συνεργασίας για την αντιμετώπιση των προκλήσεων που επιφέρει η Τεχνητή Νοημοσύνη.

Xαρακτήρισε την τεχνητή νοημοσύνη ως «την πιο αξιοσημείωτη τεχνολογική καινοτομία της εποχής μας» και τόνισε τη δέσμευσή της Ελλάδας για μια «ανθρωποκεντρική ατζέντα για την τεχνητή νοημοσύνη», βασισμένη στη διαφάνεια, την ηθική χρήση και τη λογοδοσία, ώστε να ενισχύεται η προστασία των ανθρωπίνων δικαιωμάτων και των δημοκρατικών αρχών.

Αναγνώρισε τη σύνδεση της τεχνητής νοημοσύνης με τη διεθνή ειρήνη και ασφάλεια, με αναφορά σε πολλές διεθνείς πρωτοβουλίες και σημείωσε ότι ο Έλληνας Πρωθυπουργός υπέγραψε τη «Διακήρυξη των Παρισίων για τη Διατήρηση του Ανθρώπινου Ελέγχου στα Οπλικά Συστήματα με τεχνητή νοημοσύνη», δεσμευόμενος για υπεύθυνη χρήση της στο στρατιωτικό πεδίο «σε συμφωνία με το διεθνές δίκαιο».

Η Ελλάδα προετοιμάζει εθνική συνεισφορά στην έκθεση του Γενικού Γραμματέα σχετικά με την τεχνητή νοημοσύνη και τη διεθνή ασφάλεια, ενώ οργανώνει και «Διεθνές Συνέδριο Διαχείρισης Κρίσεων» τον Μάιο, με αντικείμενο την τεχνητή στον στρατιωτικό τομέα.

Ο κ. Σέκερης κάλεσε το Συμβούλιο Ασφαλείας να μην αγνοήσει τη «διεθνή συναίνεση» για την ανάγκη ρύθμισης της τεχνητής νοημοσύνης και πρότεινε να συμπεριληφθεί σε εντολές ειρηνευτικών αποστολών η «υπεύθυνη χρήση εφαρμογών τεχνητής νοημοσύνης» με στόχο την προστασία των ειρηνευτικών αποστολών και των αμάχων, καθώς και την αντιμετώπιση «κακόβουλων κυβερνοεπιθέσεων, ρητορικής μίσους και παραπληροφόρησης».

Ιδιαίτερη έμφαση δόθηκε στην ανάγκη συμμόρφωσης με τον «Χάρτη του ΟΗΕ και το Διεθνές Δίκαιο, συμπεριλαμβανομένου του Διεθνούς Ανθρωπιστικού Δικαίου και του Δικαίου των Ανθρωπίνων Δικαιωμάτων».

Η Ελλάδα στήριξε την έκκληση του Γενικού Γραμματέα για «απαγόρευση των φονικών αυτόνομων όπλων» και τη θέσπιση περιορισμών έως το 2026, δηλώνοντας έτοιμη να συμμετάσχει στις σχετικές συζητήσεις ως «εκλεγμένο μέλος του Συμβουλίου Ασφαλείας».

Ο κ. Σέκερης έκανε έκκληση για «ενότητα, διορατικότητα και όραμα» από το Συμβούλιο Ασφαλείας, ώστε να συμβάλει «στις παγκόσμιες προσπάθειες για την αξιοποίηση ασφαλούς, και αξιόπιστης τεχνητής νοημοσύνης για τη διατήρηση της διεθνούς ειρήνης και ασφάλειας».

Ο Γιάννης Μαστρογεωργίου, Ειδικός Γραμματέας Στρατηγικής Προοπτικής της ελληνικής κυβέρνησης και συντονιστής της Συμβουλευτικής Επιτροπής Υψηλού Επιπέδου για την Τεχνητή Νοημοσύνη μιλώντας στη συνεδρίαση ανέφερε ότι η Ελλάδα δίνει ιδιαίτερη έμφαση στη διαμόρφωση ενός «παγκόσμιου πλαισίου για την ασφαλή, αξιόπιστη και χωρίς αποκλεισμούς Τεχνητή Νοημοσύνη (AI)».

Η χώρα μας, τόνισε, στηρίζει ενεργά τον ρόλο του ΟΗΕ ως καταλύτη για τη διαμόρφωση κοινών ηθικών και ρυθμιστικών προτύπων, με στόχο η τεχνητή νοημοσύνη να λειτουργήσει προς όφελος της ανθρωπότητας και όχι εις βάρος της διεθνούς ειρήνης και ασφάλειας. Η εθνική στρατηγική για την τεχνητή νοημοσύνη στην Ελλάδας, όπως αποτυπώνεται στον «Οδικό Χάρτη για τον Ψηφιακό Μετασχηματισμό», προτάσσει μια ανθρωποκεντρική προσέγγιση, με έμφαση στη διαφάνεια, τη δημοκρατία και τη βιώσιμη ανάπτυξη.

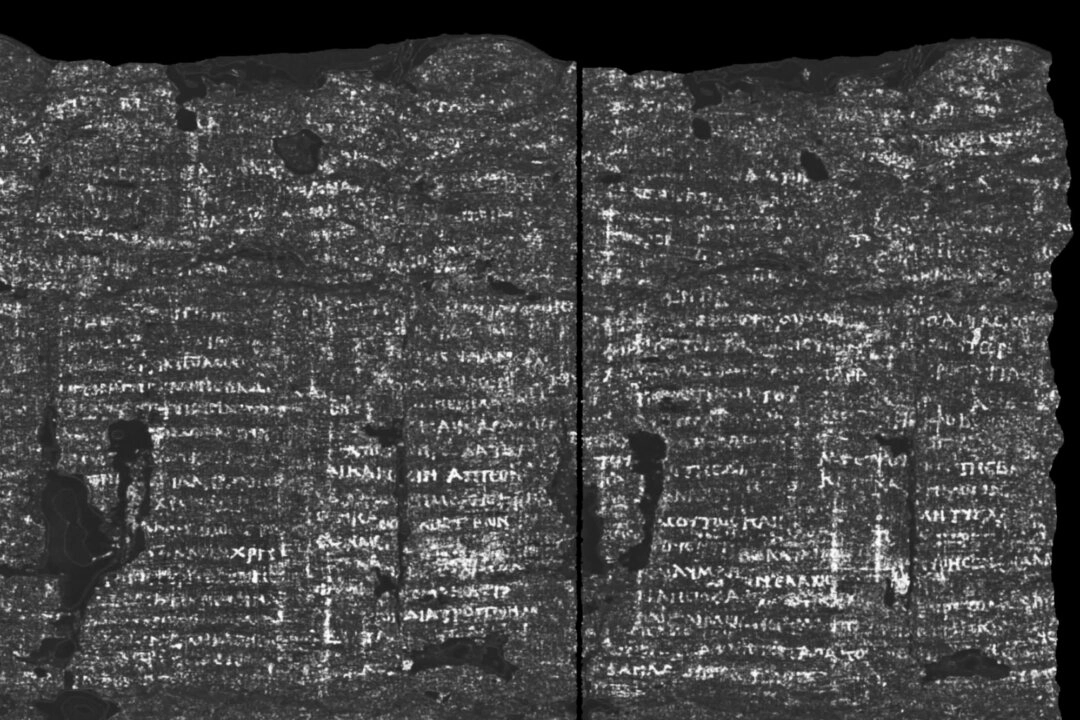

Η Ελλάδα ανέφερε, συμμετέχει σε κορυφαίες διεθνείς πρωτοβουλίες όπως η Σύνοδος Κορυφής AI στο Παρίσι, το GPAI, η Επιτροπή AI του Συμβουλίου της Ευρώπης, ενώ συνεργάζεται με κορυφαία ακαδημαϊκά ιδρύματα (Oxford, Stanford, Harvard) στο «Lyceum Project», που ενσωματώνει τις αξίες της αριστοτελικής ηθικής στη ρύθμιση της τεχνητής νοημοσύνης.

Επιπλέον, η Ελλάδα αποτελεί μία από τις 7 χώρες της ΕΕ που φιλοξενούν «AI Factories», ενισχύοντας την καινοτομία, τη σύνδεση επιστήμης και οικονομίας και την κοινωνική συνοχή.

Η ελληνική πλευρά τονίζει πως η τεχνητή νοημοσύνη δεν είναι απλώς τεχνολογία, αλλά βαθιά κοινωνική αλλαγή. Υπογραμμίζει την ανάγκη προστασίας των ανηλίκων από τους κινδύνους των εθιστικών αλγορίθμων και της ψηφιακής χειραγώγησης, ενώ στηρίζει την ένταξη της τεχνητής νοημοσύνης στην παγκόσμια ατζέντα ειρήνης και ασφάλειας του ΟΗΕ.

Η εθνική στρατηγική της Ελλάδας για την τεχνητή νοημοσύνη στοχεύει να εξασφαλίσει ότι η τεχνολογική πρόοδος θα συμβαδίζει με «την ενίσχυση των ανθρωπίνων δικαιωμάτων και των δημοκρατικών αρχών».

Στο ίδιο πνεύμα, παρουσιάστηκε το εθνικό σχέδιο «Blueprint for Greece’s AI Transformation», το οποίο καθορίζει αρχές και έργα για την πρόοδο της τεχνητής νοημοσύνης με στόχους όπως η «ενίσχυση της δημοκρατίας, η περιβαλλοντική βιωσιμότητα και η προστασία της κοινωνίας από κινδύνους μη ρυθμιζόμενης χρήσης».

Η Ελλάδα προτείνει συγκεκριμένα βήματα στο πλαίσιο του ΟΗΕ:

– «Διεθνή ερευνητικά κέντρα για την ασφάλεια και την ηθική της τεχνητής νοημοσύνης»

– «Δημιουργία διεθνούς παρατηρητηρίου τεχνητής νοημοσύνης»

– «Εξειδικευμένα φόρα διαλόγου μεταξύ υπευθύνων πολιτικής, επιστημόνων, κοινωνίας πολιτών και βιομηχανίας»

Ο κ. Μαστρογεωργίου επανέλαβε την ανάγκη λήψης μέτρων για την προστασία των παιδιών από «τους κινδύνους του ψηφιακού κόσμου, τους εθιστικούς αλγόριθμους και τους μηχανισμούς χειραγώγησης», τονίζοντας ότι η τεχνητή νοημοσύνη αποτελεί «βαθιά κοινωνική αλλαγή που επηρεάζει τον τρόπο που εργαζόμαστε, επικοινωνούμε, εκπαιδευόμαστε και μεγαλώνουμε τα παιδιά μας».

Η Ελλάδα προειδοποιεί, ανέφερε, πως χωρίς κοινό ρυθμιστικό πλαίσιο, η τεχνητή νοημοσύνη μπορεί να αυξήσει τις διακρίσεις και να απειλήσει την ειρήνη.

Κύπρος: Αξιοποίηση τεχνητής νοημοσύνης για δημόσιο καλό, οικονομική ανάπτυξη, καινοτομία

H Aναπλ. Μόνιμη Αντιπρόσωπος της Κύπρου Γαβριέλλα Μιχαηλίδου, που συμμετείχε στη συνεδρίαση τόνισε ότι η Κυπριακή Δημοκρατία θα αξιοποιήσει την τεχνητή νοημοσύνη για «το δημόσιο καλό, την οικονομική ανάπτυξη και την καινοτομία», διασφαλίζοντας ότι η ανάπτυξή της παραμένει «ηθική και διαφανής», σε συμφωνία με τα ευρωπαϊκά και διεθνή πρότυπα.

Η Κύπρος επισήμανε την ανάγκη για άμεση καθιέρωση «αρχών, των διεθνών κανόνων και κανονισμών» σχετικά με τις αναδυόμενες τεχνολογίες όπως η τεχνητή νοημοσύνη και τα αυτόνομα οπλικά συστήματα, προκειμένου να διασφαλιστεί η αποτελεσματική διαχείριση συγκρούσεων και η διατήρηση της διεθνούς ασφάλειας.

Η διαφάνεια και η ενσωμάτωση, ανέφερε, κρίνονται απαραίτητες για την αποτροπή «κακής χρήσης που θα μπορούσε να απειλήσει την πολιτική σταθερότητα, τη δημοκρατία και τη διεθνή ασφάλεια», με έμφαση στην προστασία ευάλωτων ομάδων από «δυσανάλογες βλάβες».

Τόνισε επίσης τη σημασία της διαδικασίας REAIM στη διαμόρφωση «διεθνών ηθικών προτύπων» που ενισχύουν την εμπιστοσύνη και μειώνουν τους κινδύνους που σχετίζονται με τον κυβερνοπόλεμο και τις στρατιωτικές δυνατότητες που βασίζονται στην τεχνητή νοημοσύνη.

Υπογραμμίζοντας ότι «το διεθνές δίκαιο εφαρμόζεται στην τεχνητή νοημοσύνη», η Κύπρος υποστήριξε τον ενεργό ρόλο του ΟΗΕ-ιδίως μέσω του Συμβουλίου Ασφαλείας-για την προώθηση ρυθμίσεων που αποτρέπουν «κακόβουλες ενέργειες, όπως η ανάπτυξη αυτόνομων όπλων, ο κυβερνοπόλεμος και η παραπληροφόρηση».

Σε περιβαλλοντικό επίπεδο, η Κύπρος στηρίζει λύσεις μέσω τεχνητής νοημοσύνης που μειώνουν την κατανάλωση ενέργειας και τις εκπομπές άνθρακα, στηρίζοντας τον «Συνασπισμό για Βιώσιμη Τεχνητή Νοημοσύνη» και προωθώντας πολιτικές που ευθυγραμμίζονται με τους στόχους βιωσιμότητας της ΕΕ και σε παγκόσμιο επίπεδο.

Τέλος, η Κύπρος τονίζει την ανάγκη για στενές συνεργασίες μεταξύ ΟΗΕ, κυβερνήσεων, τεχνολογικού τομέα και κοινωνίας των πολιτών ώστε να διατηρηθεί «η ακεραιότητα της πληροφορίας» και να αντιμετωπιστούν αποτελεσματικά ο εξτρεμισμός και η ρητορική μίσους, συμβάλλοντας συνολικά στην «ενίσχυση της διεθνούς ειρήνης, ασφάλειας και της συμμόρφωσης με το διεθνές ανθρωπιστικό δίκαιο».

Στη συνεδρίαση τονίστηκε η ανάγκη για μια χωρίς αποκλεισμούς και συντονισμένη προσέγγιση, ώστε η τεχνητή νοημοσύνη AI να αξιοποιηθεί για την ειρήνη και όχι για την πρόκληση συγκρούσεων.

Του Γ. Γαραντζιώτη